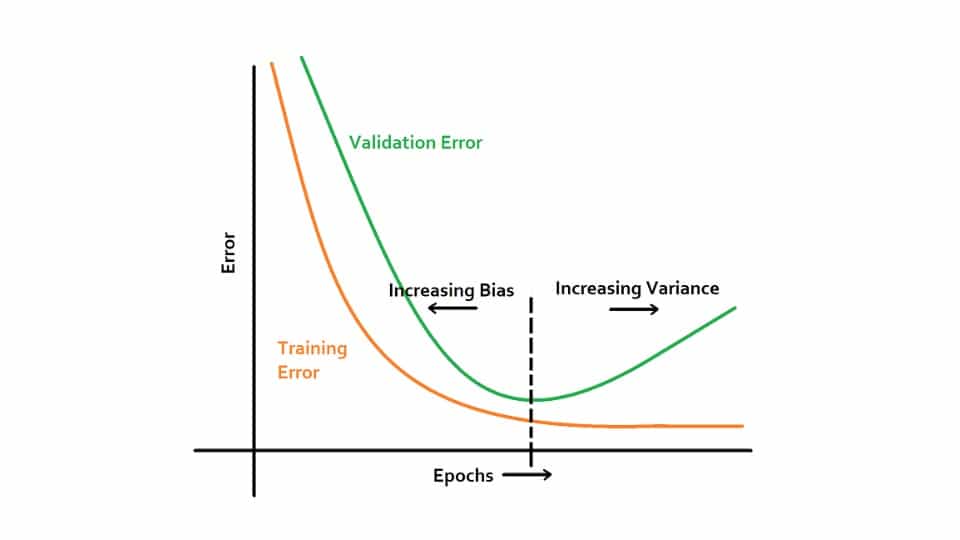

یکی از پر استفاده ترین روشها در حینِ آموزش شبکه های عصبی، روش early stopping است. فلسفه این روش به این شکل است که سعی کنیم فاصله خطای داده های آموزش و ولیدیشن زیاد نشود. اگر از روشهای مناسبِ مقداردهی اولیه استفاده کنیم، وزن ها در ابتدای کار کوچک هستند. در ادامه زمانی که overfitting تازه خودش را نشان می دهد، وزن ها متعادل هستند و هر چه به سمت overfitting پیش می رویم، وزن ها به صورت کلی بزرگتر می شوند. روش early stopping در نشان دادن این موارد خوب است ولی ضعف بزرگی دارد و آن این است که ما سعی می کنیم با یک روش هم فرآیند آموزش و هم validation را کنترل کنیم. این کار باعث می شود که کنترل کردن هر دو سخت باشد. اصولا برای مقابله با underfitting (برای آموزش) و overfitting (برای ولیدیشن) راهکارهای متفاوتی وجود دارد و وقتی سعی می کنیم هر دو اینها را با هم حل کنیم، کار پیچیده و وقت گیر می شود. بهترین کار این است که ابتدا مدل را آموزش دهیم تا ببینیم مشکل underfit ندارد، بعد سعی کنیم با ابزارهای موجود مثل dropout یا افزایش داده به overfitting فکر کنیم.

نوشته شده بوسیله:

محمد ابراهیم

سردبیر بخش هوش مصنوعی وبسایت هستم. زمینه های فعالیت من عبارت است از یادگیری عمیق، یادگیری تقویتی، بازیابی اطلاعات و بینایی ماشین. به ریاضیات، جبر و بهینه سازی علاقه فراوانی دارم. تجربیات بسیاری در برنامه نویسی دارم و فریمورکهای مورد علاقه من عبارتند از django ،pytorch و tensorflow. از دانشگاه …