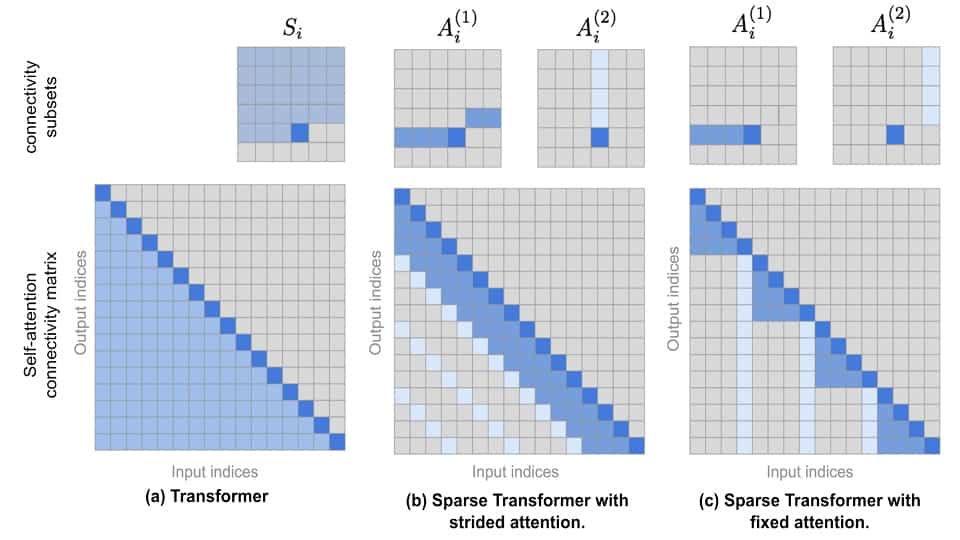

در شبکه های ترنزفرمر محاسبات متفاوتی صورت می گیرد که سبب می شوند در نهایت بتوان نگاشتهایی غیر خطی از token ها یا embedding های ورودی داشته باشیم. یکی از قسمت های مهم در این شبکه ها، قسمت مربوط به ماتریس attention است. به صورت کلی اگر نگاه کنیم، هر query لازم است میزان attention با تمامی key ها را پیدا کند؛ بر همین اساس، یک ماتریس مربعی تشکیل خواهد شد که ماتریس attention نام دارد. دقت کردن به ابعاد این ماتریس در کاربردها و سخت افزارهای مختلف اهمیت بسیار بالایی دارد. اگر طول دنباله بالا باشد، این ماتریس تعداد المانهایش خیلی زیاد می شود؛ برای مثال، اگر طول دنباله n باشد، ابعاد ماتریس توان دوم n خواهد بود. مقالات زیادی در literature سعی کرده اند که به نحوی محاسبات مربوط به این ماتریس را کم کنند یا حتی به نوعی تغییراتی در آن ایجاد کنند. دنبال کردن مقالات این زمینه برای بهبود کیفیت شبکه های ترنزفرمر بسیار حیاتی است.

نوشته شده بوسیله:

کامران پناهی

کارشناسی ارشد هوش مصنوعی

علاقه مند به یادگیری عمیق