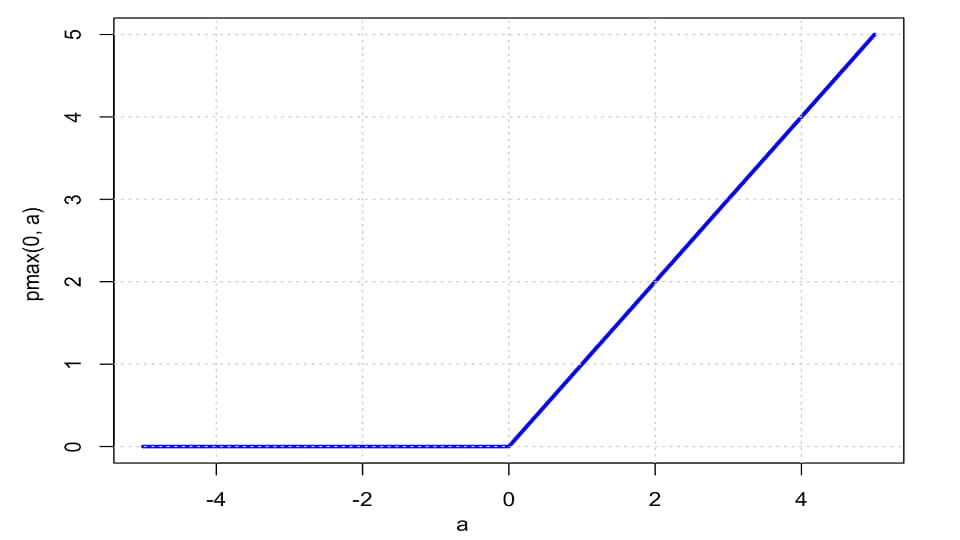

تابع ReLU در تمامی نقاط مشتق پذیر نیست

یکی از مواردی که معمولا برای همه سوال به وجود می آورد این است که چرا تابع ReLU در شبکه ها استفاده می شود با وجود اینکه مشتق پذیر نیست. به صورت کلی و ساده اگر توضیح دهیم، به این شکل است که این تابع مشتق پذیر نیست در نقطه صفر و به همین دلیل از روش subderivative استفاده می کنیم. ویژگی این تابع محدب بودن است. ایده این است که اینجا مشتق نداریم و مشتق چپ و راست برابر نیستند اما اگر تابع محدب باشد می توان در نقطه مشتق ناپذیر مشخص کرد که شیب های خطوط مماس در چه بازه ای قرار می گیرند. حال می توان از آن بازه یک عدد را به عنوان مشتق استفاده کرد تا back propagation داشته باشیم. برای آشنایی با روش subderivative می توانید این ویدیو را مشاهده کنید.