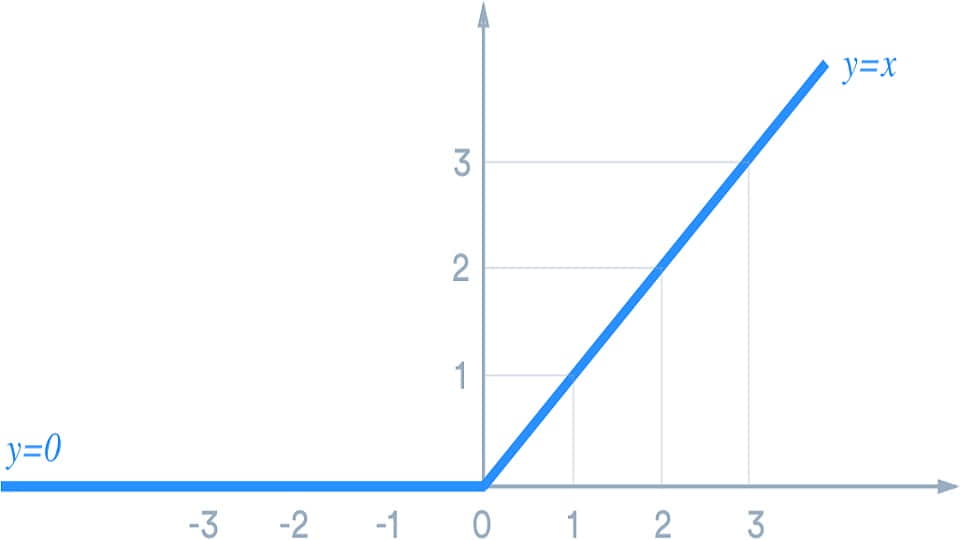

یکی از ویژگی های مهم این تابع که سبب می شود به طرز چشم گیری بهتر از توابعی مثل Tanh یا Sigmoid کار کند، ویژگی بلاک کردن این تابع برای ورودی های منفی است. این ویژگی از دو منظر قابل بررسی است. در لایه بعدی، تنها نورونهایی از لایه قبل تاثیر گذار خواهند بود که مقادیری غیر منفی دارند و عملا نوعی فیلتر سازی انجام می شود. اطلاعات نورون های بدردنخور به کل دور ریخته می شوند و در تصمیمات لایه بعد تاثیرگذار نیستند. از سویی، این تابع رفتاری مشابه با dropout دارد ولی به صورت غیر رندم؛ این به این معنی است که هر بار که داده ها را به شبکه می دهیم، دسته ای از نورونها مثل این رفتار می کنند که گویی غیرفعال هستند. یعنی به گونه ای به قدرت تعمیم شبکه هم می تواند کمک کند. با توجه به این دو ویژگی می توان توابع فعالیت جدیدی ساخت که شاید بهتر از ReLU باشند.

تابع ReLU و یکی از ویژگی های منحصر به فرد این تابع

نوشته شده بوسیله:

محمد ابراهیم

سردبیر بخش هوش مصنوعی وبسایت هستم. زمینه های فعالیت من عبارت است از یادگیری عمیق، یادگیری تقویتی، بازیابی اطلاعات و بینایی ماشین. به ریاضیات، جبر و بهینه سازی علاقه فراوانی دارم. تجربیات بسیاری در برنامه نویسی دارم و فریمورکهای مورد علاقه من عبارتند از django ،pytorch و tensorflow. از دانشگاه …