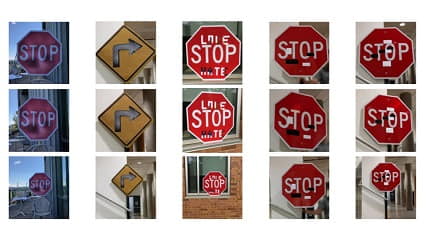

یکی از مواردی که لازم است به خصوص کسانی که تازه درسشان تمام شده لحاظ کنند، امنیت مدلهای یادگیری عمیق است. هیچ وقت به مدلتان اعتماد نکنید. روند معمول به این صورت است که به شما مساله ای داده می شود و شما پس از مطالعه راه حلی را ارایه می دهید و در ادامه مدلی را آموزش می دهید. اگر از پیچیدگی این مرحله عبور کنیم و فرض کنیم که به درستی انجام می شود، در انتها مدلی بدست می آورید که روی دادگان تست خوب کار می کند. توجه کنید که اینجا کار تمام نمی شود و نباید این مدل را به عنوان مدل نهایی استفاده کرد. مدل باید در برابر حملات مقاوم شود. علت این موضوع این است که ممکن است در زمان استفاده از مدل در محیط نهایی، نمونه های خصمانه به مدل تحمیل شود. در این صورت کل سیستم زیر سوال می رود. اگر بخواهیم خیلی ساده حمله را شرح دهیم، به این شکل است که در زمان آموزش سعی می شود خطا کم شود، حال چه می شود اگر بتوان داده هایی را درست کرد که خطا را بیشینه کند. حملات متفاوتی وجود دارد و برای هر یک راه های مقاوم سازی متفاوتی وجود دارد که اینجا به جزییات نخواهیم پرداخت ولی صرفا اشاره می کنیم که مقاوم سازی در مورد حملات متفاوت نیاز است. حال چرا این موضوع اهمیت بسیار دارد؟ در تسکهایی که مربوط به خودروهای خودران هستند یا جاهایی که لازم است با توجه به چهره فرد، فرآیند شناسایی انجام شود، عملکرد دسته بند اهمیت بسیار دارد. شاید مدل شما روی داده های تست 99.999% خوب کار کند ولی با یک مثال خصمانه ساده، ممکن است سیستم خطا کند.

نوشته شده بوسیله:

کامران پناهی

کارشناسی ارشد هوش مصنوعی

علاقه مند به یادگیری عمیق