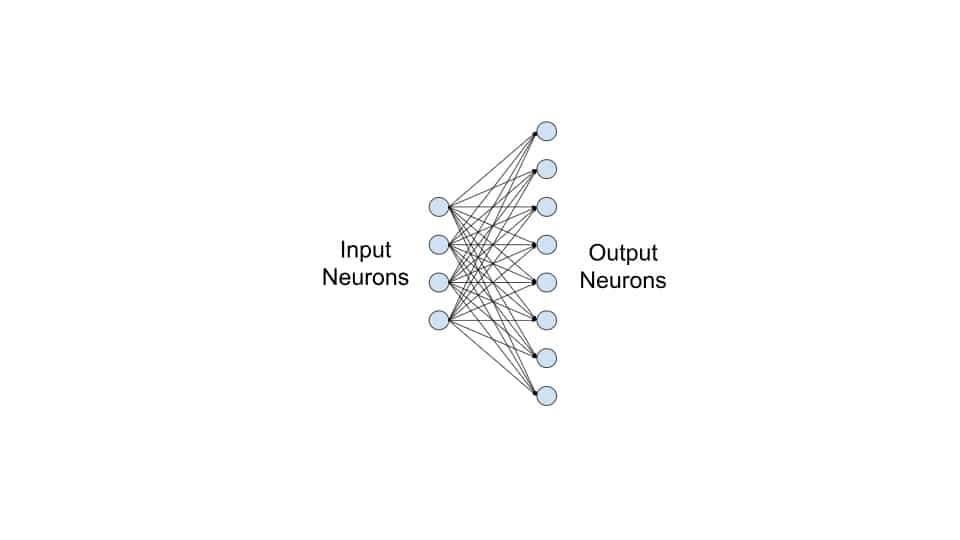

پیش از این اشاره کردهبودیم که در مقالات معمولا بدلیلِ هزینهبر بودنِ ablation study سعی میشود که روشهای جدیدی که سایرین درست کردهاند استفادهنشود مگر اینکه نوآوری در کار باشد. ولی در کارهای تجاری دست مهندسِ شبکه خیلی باز است و میتواند از روشهای متفاوتی استفادهکند. با این وجود شاهد این هستیم که معمولا اینکار صورت نمیگیرد. برای روشن شدن ماجرا، احتمالا همه زمانِ ساختِ شبکههای پیچشی از لایههای تماماتصالِ عادی استفاده کردهباشیم؛ با این حال، در این زمینه مطالعاتِ فرآوانی صورت گرفته است که چگونه عملکردِ لایههای تماماتصال بهبود بخشیدهشوند. به عنوانِ مثالی ساده، خیلی از افراد برای بهبودِ کیفیتِ شبکههای پیچشی به سراغ جدیدترین مدلهای شبکههای پیچشی میروند که در لایههای پیچشی تغییراتی بوجود آوردهاند ولی میتوان با استفاده از لایههای عادیِ پیچشی و روشهای بهبودیافته در لایههای تماماتصال نتیجه را خیلی خوبکرد. اگر بخواهیم به دستهای از مقالات اشارهکنیم، مقالهی بسیار قدیمیِ generalized feedforward neural network architecture را معرفی میکنیم و اینکه استفاده از همین تغییر کوچک تا چه میزان میتواند در بهبودِ کیفیتِ شبکه تاثیرِ مثبت داشتهباشد. توجه کنید که معمولا دو سه لایهی آخرِ شبکههای پیچشی تقریبا در تمامیِ معماریها شبیه به هم هستند ولی ما اصرار داریم که سعی کنید جاهایی را که معمولا کسی با آنها کاری ندارد و همه ثابت در نظر میگیرند را بهبود بخشید.

نوشته شده بوسیله:

محمد ابراهیم

سردبیر بخش هوش مصنوعی وبسایت هستم. زمینه های فعالیت من عبارت است از یادگیری عمیق، یادگیری تقویتی، بازیابی اطلاعات و بینایی ماشین. به ریاضیات، جبر و بهینه سازی علاقه فراوانی دارم. تجربیات بسیاری در برنامه نویسی دارم و فریمورکهای مورد علاقه من عبارتند از django ،pytorch و tensorflow. از دانشگاه …